Onderwerpherkenning door AI en deep learning technologie

De laatste jaren is er in introductieteksten voor camera’s steeds vaker sprake van artificiële intelligentie, machine learning en deep learning. Zijn dat allemaal loze kreten of zit er werkelijk wat achter en zo ja wat?

Dit artikel is geschreven door Dré de Man en gepubliceerd in DIGIFOTO Pro 1.2023

Ai, machine learning en deep learning

Fujifilm spreekt bij de introductie van de FUJIFILM XT-5 van deep learning voor de onderwerpherkenning en van AI voor de witbalans. Canon gebruikt ook de term deep learning en Sony heeft regelmatig termen als machine learning gebruikt. Nikon maakte bij de introductie van de Z 9 bekend gebruik te maken van deep learning en dat zijn maar een paar voorbeelden. Dat soort termen zijn natuurlijk een godsgeschenk voor de marketingafdeling, maar kunnen we op basis van de marketinguitlatingen iets zeggen over de verschillen tussen de merken? Nee. Maar we weten wel zeker dat veel camerafabrikanten gebruik maken van deze technieken.

Zo werd de Sony A9 nog gepresenteerd zonder die termen, maar in 2018 kreeg de camera met de introductie van de A7III een firmware-update en toen was er in ineens wel oogherkenning. De Nikon-camera’s Z 6 en Z 7 werden in datzelfde jaar eveneens geïntroduceerd zónder eye-AF net als de Canon EOS R maar beide merken wisten dat gemis binnen enkele maanden goed te maken. Daarop volgde onderwerpherkenning: dat begon met ogen van dieren, eerst honden en katten, maar daarna volgden de dieren zelf, vliegtuigen, auto’s motoren en fietsen, zo langzamerhand zijn er maar weinig bewegende onderwerpen die niet door camera’s worden herkend.

Dat al die verschillende cameramerken zo snel hun camera’s konden aanpassen maakt duidelijk dat we hier met een bijzondere manier van het schrijven van software te maken hebben. Zou het om de gebruikelijke technieken gaan, dan zou het ook nooit zo snel gaan en bovendien waren er dan patenten die het onmogelijk zouden maken min of meer op dezelfde wijze te werk te gaan. Om te begrijpen hoe het nu allemaal werkt, moeten we teruggaan in de tijd.

Heel lang geleden, in de tijd van de Nikon FG? was er al sprake van een eenvoudige soort van onderwerpsherkenning. Bij de toen revolutionaire matrixmeting gebruikte de camera een database met duizenden scènes, en aan de hand daarvan werd de belichting bepaald – of gecorrigeerd. Al die verschillende scènes zijn geanalyseerd en zo konden camera’s dan uiteindelijk scènes herkennen: als het een beeldvlak 65 procent helderheid had en door een horizontale lijn werd gescheiden van een ander met 31 procent helderheid, dan wist de camera dat het een landschap was met lucht daarboven. Maar daarvoor moesten talloze medewerkers nog foto ‘s analyseren en nameten en softwareontwikkelaars moesten dan ook nog eens allerlei algoritmen schrijven die bepaalden wat de camera in allerlei verschillende situaties zou doen. Op diezelfde manier hebben verschillende cameramerken gedurende vele jaren langzaam maar zeker belichting en scherpstelling geperfectioneerd.

Onmogelijk

Maar bij geavanceerde beeldherkenning, bijvoorbeeld het herkennen van een oog in een gezicht of nog moeilijker, van een vogel dan wel een auto, is het vrijwel onmogelijk om daar handmatig reeksen van data voor te genereren, er is bijna een oneindig aantal verschillende reeksen beelddata mogelijk. De complexiteit van de op basis daarvan te schrijven algoritmen is zo mogelijk nog veel groter, kortom: zoiets is menselijkerwijs gesproken onmogelijk.

Voor een supercomputer, of een grote verzameling van samenwerkende gewone computers, is het echter een koud kunstje. Dat wil zeggen: als je dan ook nog eens software gebruikt die zichzelf schrijft. Wat het nóg gemakkelijker maakt: bedrijven als Amazon Web Servies, Microsoft en Google kunne je grote verzamelingen computers én de bijbehorende software om software te schrijven per uur uitlenen voor een habbekrats. Dan laat je het systeem steeds foto’s van vogels zien en vertel je het systeem op welke foto’s vogels staan en op welke niet. Het moeilijke werk: het schrijven van de algoritmen voor de onderwerpsherkenning, doet de software van Amazon, Google of Microsoft automatisch.

Toch komen er nog steeds mensen aan te pas. Allereerst moeten die het domme werk doen. Dat komt neer op het ‘voeren’ van foto’s aan de software en daarbij aangeven of er goed of niet goed scherpgesteld (of belicht) is. De rest doet de software dan. Maar dat gaat niet in alle gevallen feilloos. Een van de DPR-redacteuren wist in 2018 te melden, dat de Sony A7III camera zijn schoenen ook aanzag voor menselijke gezichten – en dat waren hele gewone schoenen. Dat soort fouten maakt de Sony-software allang niet meer – maar ook die van de concurrentie niet. De camera’s uit die jaren zijn sterk verbeterd door de opeenvolgende firmware-updates. Ook opvallend: de voorsprong die Sony had, duurde niet lang. De cameramerken zitten elkaar op de hielen.

Verschillen

Toch blijven er belangrijke verschillen bestaan. Dat heeft vooral te maken met de hardware. Allereerst is er een groot verschil tussen reflexcamera’s en spiegelloze camera’s. Bij reflexcamera’s kan er geen gebruik gemaakt worden van het normale beeldsensor, want de spiegel zit in de weg. Daarom hebben die camera’s speciale sensoren, die het beeld dat via de spiegel weerkaatst wordt, analyseren. (De scherpstelsensoren doen niet mee bij de onderwerpsherkenning.) Uiteraard is zo’n sensor kleiner dan een echt beeldsensor en dus zijn er minder mogelijkheden. De precisie is zodanig veel kleiner, dat eye-AF voor de meeste reflexcamera’s een onmogelijke opgave is – behalve in Live View dan.

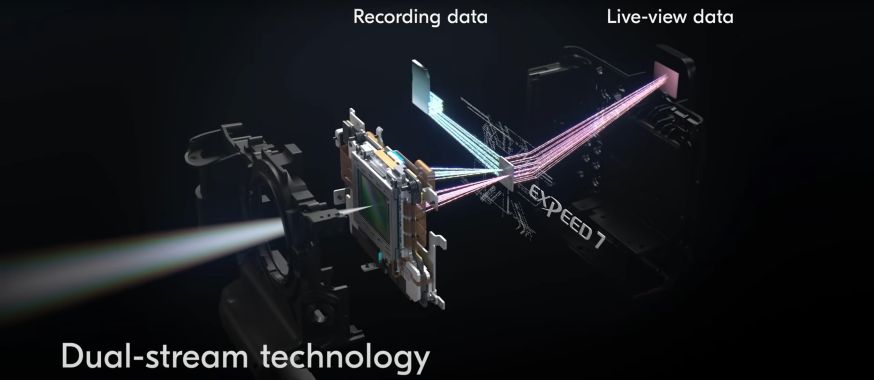

Maar ook bij spiegelloze camera’s zie je grote verschillen. Niet alleen zijn er verschillen in de aantallen types beeldpunten die gebruikt worden om mee scherp te stellen. Een veel belangrijker verschil zit in de beeldverwerkende processoren en het geheugen. Die processoren en die geheugens worden met iedere generatie sneller en beter. Het beeld van de sensor moet namelijk nog verwerkt worden, voordat er überhaupt beeldherkenning kan plaatsvinden.

Bij de snelste spiegelloze camera’s gebeurt dat met behulp van een speciale extra laag (stack) op de beeldsensor. Verder is er dan bij de camera’s die daar niet over beschikken weer verschil tussen de diverse beeldverwerkende processoren en de daaraan gekoppelde geheugens. Dan is er ook nog verschil tussen de scherpstelsensoren. Bij onder meer Panasonic zijn er helemaal geen sensoren: die camera’s gebruiken contrastgebaseerde scherpstelling. Canon gebruikt weer Dual pixels op de beeldsensor, en Nikon en Sony gebruiken fase-gebaseerde kleine sensoren op de beeldsensor. Daarom zien we dus wel verschillen tussen de merken, maar waar het gaat om de toepassing van machine learning (of machine learning) werken ze op dezelfde wijze.

Conclusie

De laatste vijf jaar is er een enorme stroomversnelling op gang gekomen die software en de hardware voor autofocus en beeldherkenning steeds verder perfectioneert. Technieken als deep learning zijn geen loze kreten; zij maken die ontwikkelingen mogelijk. Zeer waarschijnlijk staan we pas aan het begin van een fascinerende ontwikkeling.

Lees ook: De slimste technieken voor verscherpen in Photoshop en Lightroom